蕭乃彰、章勁松》人工智慧的傲慢與偏見

鉅亨網新聞中心

筆者日前受邀參加由臺北醫學大學舉行的「台灣醫療人工智慧創新研究中心」 (Artificial Intelligence for Medicine & Health Innovations, AIMHI) 開幕儀式,見證了 AIMHI 做為醫療界先驅投入促進醫療人工智慧技術與應用發展的開端工作。AIMHI 是由臺北醫學大學醫學科技學院的李友專院長倡議創立,旨在建立醫療巨量數據資料庫,跨領域性的整合醫學、神經科學、資訊科學、心理學、與哲學等學科研究,關注的議題很多,其中一項很特別的是重視發展以辨識並分析病人的個性及情緒感受為核心的「人工同理心」。

在另一個場合與工業技術研究院的賴才雅博士談話中,才得知台灣的研究團隊在人工智慧方面有很多傑出的表現,例如當初 IBM DeepQA 計劃的人工智慧系統 Watson 在尋求其自動推理與機器深層學習的應用面時,是參考了賴博士及工研院團隊的建議,才能獲得突破進一步發展出 Watson Health for Oncology,利用人工智慧來分析解讀大量的數據,輔以豐富的全球治療癌症的經驗與知識,再根據病患個人的狀況與特性,協助臨床醫師進行有實證醫療分析為根據的治療決策。

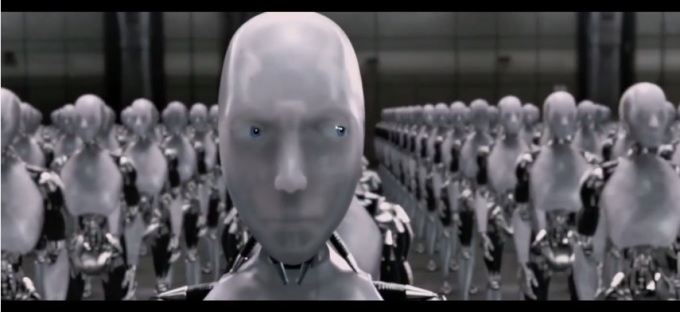

人工智慧應該是近幾年最火熱的媒體報導主題之一,新的技術、新的應用不斷刺激人們對未來的想像,人工智慧顯然將對人類生活有莫大的幫助令人振奮,但從經驗來說很少有事物會只帶來全然的好處,所以自然有人從不同的角度去觀察、預測這些新變化提出一些反思,像是人工智慧會不會太過客觀,太實事求是而沒有人性?不過從某些例證來看,除了對於人工智慧會太像機器人一般的冷冰冰的憂慮外,我們也可能要反過來擔心人工智慧會太像人類了,尤其太像人性中的一個黑暗面: 充滿狹隘的傲慢與偏見。

根據美國媒體報導,Google 已經正式向一名非裔美國人表示道歉,因為 Google Photos 竟然把他及一位非裔美國人的朋友臉部照片分類為「gorillas (大猩猩)」的類別標籤。Google 發表正式聲明表示,正試圖弄清楚這項冒犯種族忌諱的標籤是怎麼發生的,答案可能是 Google Photos 面部識別技術中的一個錯誤。

Google 發言人說:「我們對此感到震驚和誠摯歉意,自動圖像標記工作還有很多改善要完成,我們正在研究如何防止這類型的錯誤再度發生。」短期內,Google Photos 會停止將「大猩猩」的標籤作為一個類別使用,之後他們會弄清楚如何從根本上改變機器學習系統,以更多的背景來加強電腦對人類文化的理解,以對可能令人反感的語言更加敏感。

人類社會化的基石是語言,然而偏見也是通過我們的語言來傳遞的。當電腦學習人類語言時,它們也一併接收了人類的偏見,例如將負面的詞語與非裔美國人的名字串聯起來。而隨著人工智慧演算法在醫療保健、刑事司法、財務投資、軍事國防、和許多專業領域的決策上越來越普遍,它們的設計者必須意識到他們編碼或定義時可能潛藏或夾雜的偏見及誤導性。

ProPublica 一項分析指出,在許多美國的州法院會使用的犯罪風險評估分數,系統中的統計模式明顯的將非裔罪犯標示可能再犯的風險分數,打得比白種人罪犯多兩倍以上,這意味著非裔比較不容易得到法院的假釋,而且會為了相似的犯罪行為比白人罪犯在監獄中待上更久的時間。

更糟糕的是,雖然被標籤為高風險的非裔,在兩年內再犯罪的比例是低於 20%,而被標籤為低風險的白人,兩年內再犯的比例卻高達 60% 以上,此套系統卻將在美國司法部的建議下,由國會通過在全美的聯邦監獄使用,做為保釋、緩刑、量刑、和假釋決定的主要評估依據。

當類似的刻板印象轉化到 AI 應用,可能產生更不易發現的誤區,而因性別、年齡、少數族裔、社會弱勢等各種區分方式對非屬主流的群體造成影響,而由於多數人難以接觸或理解這些應用形成分析結果的過程,使得這些應用更難被糾錯或被挑戰。

在未來的人工智慧的決策機器中,我們希望有更多的資料庫、更多的實證基礎、以及更多的自動化,來消除人類主觀的偏見,但當我們被人工智慧診斷患有某種疾病的機率、何種工作最適合我們、銀行貸款是否可以核可、或者我們是不是應該被列入恐怖分子的名單,我們應該有權去了解電腦如何控制與衡量證據。

不過由於電腦的內部演算被當作是商業秘密時,廠商嚴格保護人工智慧建構算法的智慧財產權,即使是在公共領域使用這些演算法,這些機器演算法仍難以被查詢或檢驗,也就是說實際上根本就不知道它們如何推算出結論的。

因此有一種觀點認為,能夠詢問人工智慧系統是如何得出其結論應該要是一項合法的基本權利。從 2018 年的夏季開始,歐盟可能要求人工智慧系統公司要能夠向用戶解釋自動化系統的決策。有些表面上看起來相對簡單的系統 (例如利用瀏覽習慣在使用者的網頁上來投放廣告或推薦歌曲),可能即使是建構這些應用程式的工程師,也不能完全解釋它們的行為,如果個體能有個參與或更改定義的機會,而非僅被動接受陌生的第三者定義,會不會降低有問題的定性歸納形成,就像是 Google Photos 所發生的問題或更糟糕的情況?也避免商業團體透過數據分析結果後,所進行精準行銷或針對性的新聞或訊息提供,而宰制、限縮了人們自我選擇的空間與能力?

從另一個角度來看權責分配也可能出現某些問題,正因為人工智慧的深度學習是一個特別的黑盒子,如果有犯人因為聯邦監獄犯罪風險評估分數低而獲得保釋,但出獄又再度開槍傷人的話,原本應該負責的人員因為更容易責怪是電腦和人工智慧的判斷誤失,反而不必承擔責任,或者因為系統的複雜性與權威性,使得執行者即使有疑惑卻更難對系統所形成有問題的指令提出質疑?

如果上帝是以自己的形象創造了人類,現在人類也正在努力以同樣的方式編寫人工智慧的腳本。正因為人工智慧是我們文化的延伸,而且有著革命性的巨大潛力,我們必須正視人工智慧或許可能和它的設計者一樣正直有品德,但也可能隱含著人類潛在的缺陷與偏見,在資訊相關科技發展常採用且難以避免的試錯 (trial and error) 中,我們不至於需要過度反應採取否定或抵抗的態度,但如果能對這些缺陷存在的可能性保持一定程度的關注,才有機會想到不時回頭檢視看看。

●作者:蕭乃彰/蕭中正醫療體系營運長、美國波士頓大學 M.D., Ph.D.

章勁松/法律財經專家、哈佛大學法學碩士、北京大學光華管理學院 EMBA

●本文為作者評論意見,不代表《NOWnews 今日新聞》立場。

『新聞來源/NOWnews http://www.nownews.com/』

- EBC全球百萬美金交易大賽 立即體驗

- 掌握全球財經資訊點我下載APP

上一篇

下一篇